DIGITIMES預估全球AI伺服器出貨總量將達逾181萬台,年增26.3%,其中搭載高頻寬記憶體(HBM)的高階AI伺服器出貨,則將有機會突破百萬台大關、年增四成以上。

DIGITIMES分析,以高階AI伺服器的採購對象而言,因商用圖形處理器(GPU)叢集(cluster)效能進展迅速,以及部分雲端用戶加快AI特殊應用積體電路(ASIC)採用步調,預期2025年北美大型雲端業者的採購比重將回升至7成。

DIGITIMES指出,2025年高階AI伺服器採購量成長最快的預估為甲骨文(Oracle),主因甲骨文為OpenAI的星際之門計畫(Stargate Project)合作業者中最積極者之一;而北美4大雲端業者2025年仍將採購大量高階AI伺服器,並以微軟(Microsoft)採購成長幅度最高,將近8成;Google採購量預期仍將排名第一,但其採購速度將為4大業者中最慢。

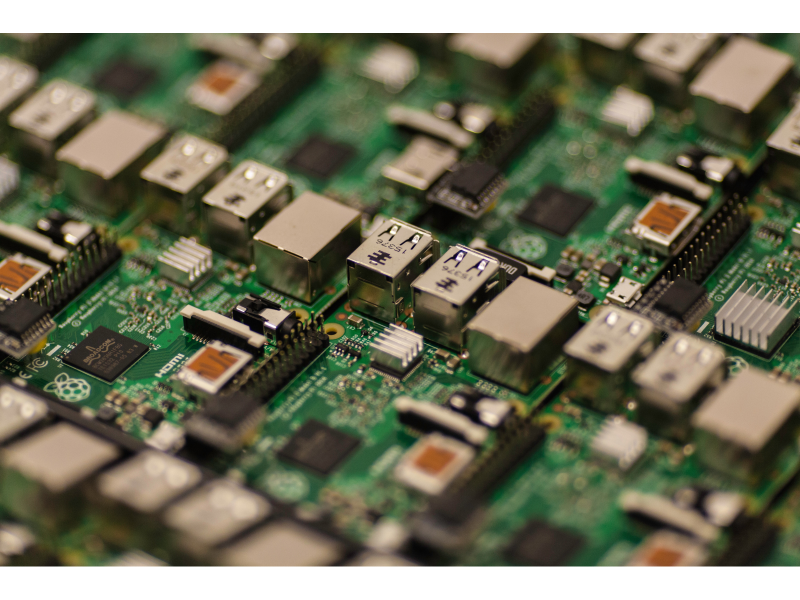

AI伺服器是什麼?跟一般伺服器有何不同

一般伺服器以中央處理器(CPU)為主要運算核心,圖形處理器(GPU)僅為輔助;而AI伺服器則相反,以GPU為主要運算引擎,CPU為輔,並常搭配特殊用途晶片,如 ASIC、FPGA、TPU 等,以滿足人工智慧訓練與推論所需的大量平行計算需求。

AI伺服器製造階段解析:

L1~6主要以各種模組組裝為主,出貨為主機板形式;L7~L9階段再加上CPU、GPU、HDD、記憶體等關鍵零組件;L10進行系統組裝與測試;L11是整機櫃組裝,也是多數台灣ODM廠做到的層級。

整體AI伺服器市場而言,做到L10~L12系統階段相對而言需整合更多元件或軟硬體整合,技術層次較高及競爭力愈強,可進攻雲端客戶的整套解決方案,例如鴻海、廣達、緯穎等,皆是以這類型的業務為主。

AI伺服器的優勢

效能最佳化與高度擴展性

AI伺服器可以根據不同工作的效能需求,搭配出最合適的硬體架構,以達到系統所需的低延遲與高吞吐量,確保運算效率最佳化。

採用模組化設計,根據實際需求擴充運算、儲存和以及網路等,靈活支撐從邊緣端到雲端的各種工作負載。

深度學習訓練與推理應用

大型AI模型訓練需要極大量資訊運算,高效能的GPU伺服器能讓訓練時間從數週縮短至數小時,提升模型精確度,即時影像辨識、語音助理等應用,要求快速回應與高可用性,AI伺服器能在雲端或邊緣端就近部署,滿足低延遲服務需求。

IT運維

結合AI演算法與大數據分析,用於自動化故障檢測、事件關聯與資源管理,分析工業設備感測數據,提早預測元件故障安排維修,提升資料中心或雲端基礎設施的穩定性。

自主系統

自駕車、無人機、機器人等系統需要即時感知數據,AI伺服器可以提供關鍵的運算支援,確保系統反應速度與穩定性。

相關伺服器概念股